1. HDFS對底層的磁盤存儲如何選擇的?

一個HDFS集群,會有很多個datanode節(jié)點(diǎn),每個datanode節(jié)點(diǎn)會掛載很多塊磁盤。HDFS在存儲數(shù)據(jù)時如何動態(tài)負(fù)載均衡最優(yōu)化地往每個datanode,每個磁盤上存儲數(shù)據(jù)呢?

其實(shí)沒啥,DataNode在運(yùn)行過程中,為了計(jì)算DN的capacity使用量,實(shí)現(xiàn)數(shù)據(jù)存儲的動態(tài)均衡,DN會對已配置的數(shù)據(jù)存儲路徑(dfs.datanode.data.dir)進(jìn)行du -sk操作,以此獲得capacity使用量匯報(bào)給NN中,然后NN就知道哪些DN有空間能被寫數(shù)據(jù)進(jìn)去,哪些是空間不足的。

為了保證數(shù)據(jù)使用量的近實(shí)時性,目前DN是以默認(rèn)10分鐘的間隔時間執(zhí)行一次。假設(shè)按照一個DN節(jié)點(diǎn)12個數(shù)據(jù)目錄對應(yīng)12塊盤的情況,就會有12個du操作在每個10分鐘內(nèi)都會執(zhí)行一次。在datanode存儲的數(shù)據(jù)使用率比較高的時候,會十分消耗性能。直接引發(fā)阻塞io,系統(tǒng)load直線增高。

這種問題在大規(guī)模的集群中是很常見的,下面是針對線上(hadoop2.6版本的)簡易零時的優(yōu)化手段。說明:此問題僅存在于低于hadoop2.8版本,高于此版本已經(jīng)修復(fù)。

https://issues.apache.org/jira/browse/HADOOP-9884

如果碰到這種情況,升級不了集群版本,那么我們還有其他奇技淫巧嗎?

2.通過修改HDFS代碼實(shí)現(xiàn)優(yōu)化

先回顧一下du,df的使用

du原理簡述:

du命令全程disk usage,它的統(tǒng)計(jì)原理在于將目標(biāo)路徑下的當(dāng)前沒有被刪除的文件進(jìn)行大小累加,然后得出總使用量。這種計(jì)算方式在文件數(shù)量少時往往不會表現(xiàn)出什么問題。但是當(dāng)目標(biāo)路徑目錄多,文件多的時候,du會表現(xiàn)出明顯的時間執(zhí)行耗時。

df 原理簡述:

df命令統(tǒng)計(jì)值通過文件系統(tǒng)獲取的。df命令的弊端是它不能按照具體目錄進(jìn)行使用量的統(tǒng)計(jì)。df是按照所在磁盤級別進(jìn)行統(tǒng)計(jì)的。換句話說,用df命令在屬于同一塊物理盤的子路徑下執(zhí)行df命令,獲取的值會是完全一致的。比較遺憾,這種情況將無法支持DataNode多block pool共用一塊盤的情況。

處理方式:使用 df 命令替換 du

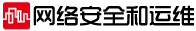

捕獲到datanode執(zhí)行過程中調(diào)用的 du -sk 命令,替換為df -k 。

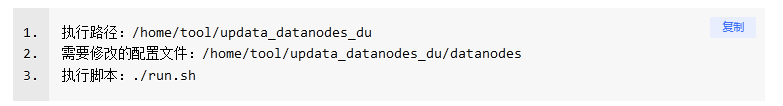

實(shí)現(xiàn)腳本如下:

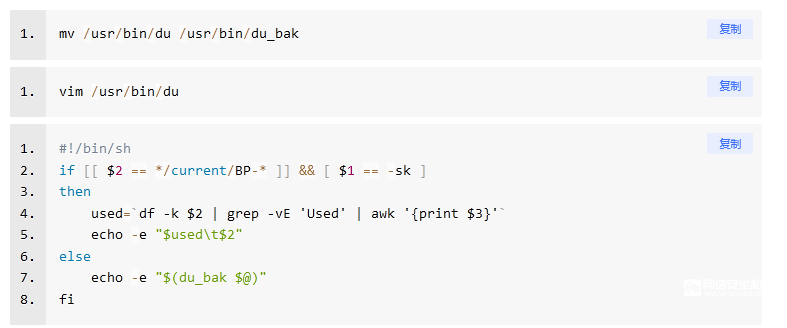

##將原始的 du指令更換名稱